Что такое парсинг?

Начнем с определения. Парсинг – это метод индексирования информации с последующей конвертацией ее в иной формат или даже иной тип данных.

Парсинг позволяет взять файл в одном формате и преобразовать его данные в более удобоваримую форму, которую можно использовать в своих целях. К примеру, у вас может оказаться под рукой HTML-файл. С помощью парсинга информацию в нем можно трансформировать в «голый» текст и сделать понятной для человека. Или конвертировать в JSON и сделать понятной для приложения или скрипта.

Но в нашем случае парсингу подойдет более узкое и точное определение. Назовем этот процесс методом обработки данных на веб-страницах. Он подразумевает анализ текста, вычленение оттуда необходимых материалов и их преобразование в подходящий вид (тот, что можно использовать в соответствии с поставленными целями). Благодаря парсингу можно находить на страницах небольшие клочки полезной информации и в автоматическом режиме их оттуда извлекать, чтобы потом переиспользовать.

Ну а что такое парсер? Из названия понятно, что речь идет об инструменте, выполняющем парсинг. Кажется, этого определения достаточно.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

Подписаться

Парсер инстаграм: сбор аудитории, аккаунтов, номеров

Парсер инстаграм — инструмент для сбора и фильтрации данных и ааудитории в инстаграме. С помощью него можно собрать базу потенциальных подписчиков, клиентов и покупателей для продвижения вашей страницы и бизнеса в инстаграме. Готовую базу можно отфильтровать по различным параметрам, которые макимально удовлетворят ваши запросы. При необходимости можно заниматься мониторингом страниц конкурентов. Благодаря парсингу в инстаграме вы будете находить только лояльных пользователей, которые положительно отреагируют на вашу рассылку или массфолловинг с масслайкингом. Получайте высокую конверсию и естественный прирост подписчиков благодаря качественной и точной фильтрации парсера инстаграм. Пройдемся по основным возможностям сбора аудитории в инстаграме.

Парсинг инстаграм может быть нескольких видов

— Парсинг подписчиков и постов аккаунта в инстаграме.

— Парсинг аккаунтов с лайков и комментариев поста.

— Парсинг аккаунтов и постов по геолокации.

— Парсинг аккаунтов и постов по геолокации

Шпион в инстаграм: слежка за пользователями

— Мониторинг новых подписчиков, постов, лайков, комментариев на аккаунтах.

— Мониторинг новых лайков и комментариев на постах.

— Мониторинг новых постов по хэштегам и геолокациям.

Фильтрация после парсинга в инстаграм

После завершения работы парсера инстаграм, собранную аудиторию можно отфильтровать по следующим характеристикам:

— Приватности профиля: открытый, закрытый, не имеет значения;

— Наличию аватарки;

— Типу аккаунта: бизнес или обычный;

— Наличию сторис;

— Количеству подписчиков у аккаунта;

— Количеству подписок у аккаунта;

— Количеству постов у аккаунта;

— Коэффициент вовлеченности по лайкам *;

— Коэффициент вовлеченности по комментариям *;

— Соотношение подписчиков и подписок;

— Дате публикации последнего поста;

— По наличию ключевого слова в описании аккаунта;

— По наличию ключевого слова в категории аккаунта;

— По наличию стоп слова в описании аккаунта.

* Коэффициент вовлечённости рассчитывается по такому принципу: (количество лайков/комментариев с 9 последних постов деленное на 9 и деленное на количество подписчиков

Ознакомившись с опциями данного инстаграм парсера можно понять, что вы получите не только точную выборку аккаунтов по нужным вам критериям, но и то, что все эти аккаунты будут живыми людьми. Парсер инстаграм будет обходить стороной аккаунты с накрученными ботами, которые не принесут вам никакой пользы, а только зря потратят время. А функция шпиона будет собирать только активных подписчиков конкурентов, которых при грамотном подходе можно легко переманить к себе, например с помощью функций МФ/МЛ или рассылки в директ, а также следить за тем, какой контент наиболее заходит для вашей целевой аудитории. Работа этого инстаграм парсера не пройдет вхолостую и положительно скажется на продвижении вашего аккаунта.

Что документируется в разделе аутентификации

В документации API не нужно подробно объяснять внешним пользователям, как работает аутентификация. Отсутствие объяснений внутренних процессов аутентификации, является лучшей практикой, поскольку хакерам будет сложнее злоупотреблять API.

Тем не менее нужно объяснить необходимую информацию:

- как получить API ключ;

- как пройти аутентификацию запроса;

- сообщения об ошибках, связанных с неверной аутентификацией;

- чувствительность информации аутентификации;

- период действия токена доступа (авторизации).

Если есть открытый и закрытый ключи, нужно объяснить, где следует использовать каждый ключ, и отметить, что закрытые ключи не должны использоваться совместно. Если разные уровни лицензий предоставляют разный доступ к вызовам API, эти уровни лицензирования должны быть явно указаны в разделе авторизации или в другом месте.

Поскольку раздел API ключей важен, и нужен разработчикам до того, как они начнут использовать API, этот раздел должен быть в начале руководства.

Где найти парсер?

Добыть утилиту для поиска и преобразования информации с сайтов можно четырьмя путями.

- Использование сил своей команды разработчиков. Когда в штате есть программисты, способные создать парсер, адаптированный под задачи компании, то искать другие варианты не стоит. Этот будет оптимальным вариантом.

- Нанять команду разработчиков со стороны, чтобы те создали утилиту по вашим требованиям. В таком случае уйдет много ресурсов на создание ТЗ и оплату работы.

- Установить готовое приложение-парсер на компьютер. Да, оно тоже будет стоить денег, но зато им можно воспользоваться сразу. А настройки параметров в таких программах позволяют точно настроить схему парсинга.

- Воспользоваться веб-сервисом или браузерным плагином с аналогичной функциональностью. Встречаются бесплатные версии.

При отсутствии разработчиков в штате я бы советовал именно десктопную программу. Это идеальный баланс между эффективностью и затратами. Но если задачи стоят не слишком сложные, то может хватить и облачного сервиса.

Обзор лучших парсеров

Далее рассмотрим наиболее популярные и востребованные приложения для сканирования сайтов и извлечения из них необходимых данных.

В виде облачных сервисов

Под облачными парсерами подразумеваются веб-сайты и приложения, в которых пользователь вводит инструкции для поиска определенной информации. Оттуда эти инструкции попадают на сервер к компаниям, предлагающим услуги парсинга. Затем на том же ресурсе отображается найденная информация.

Преимущество этого облака заключается в отсутствии необходимости устанавливать дополнительное программное обеспечение на компьютер. А еще у них зачастую есть API, позволяющее настроить поведение парсера под свои нужды. Но настроек все равно заметно меньше, чем при работе с полноценным приложением-парсером для ПК.

Наиболее популярные облачные парсеры

- Import.io – востребованный набор инструментов для поиска информации на ресурсах. Позволяет парсить неограниченное количество страниц, поддерживает все популярные форматы вывода данных и автоматически создает удобную структуру для восприятия добытой информации.

- Mozenda – сайт для сбора информации с сайтов, которому доверяют крупные компании в духе Tesla. Собирает любые типы данных и конвертирует в необходимый формат (будь то JSON или XML). Первые 30 дней можно пользоваться бесплатно.

- Octoparse – парсер, главным преимуществом которого считается простота. Чтобы его освоить, не придется изучать программирование и хоть какое-то время тратить на работу с кодом. Можно получить необходимую информацию в пару кликов.

- ParseHub – один из немногих полностью бесплатных и довольно продвинутых парсеров.

Похожих сервисов в сети много. Причем как платных, так и бесплатных. Но вышеперечисленные используются чаще остальных.

В виде компьютерных приложений

Есть и десктопные версии. Большая их часть работает только на Windows. То есть для запуска на macOS или Linux придется воспользоваться средствами виртуализации. Либо загрузить виртуальную машину с Windows (актуально в случае с операционной системой Apple), либо установить утилиту в духе Wine (актуально в случае с любым дистрибутивом Linux). Правда, из-за этого для сбора данных потребуется более мощный компьютер.

Наиболее популярные десктопные парсеры

- ParserOK – приложение, сфокусированное на различных типах парсинга данных. Есть настройки для сбора данных о стоимости товаров, настройки для автоматической компиляции каталогов с товарами, номеров, адресов электронной почты и т.п.

- Datacol – универсальный парсер, который, по словам разработчиков, может заменить решения конкурентов в 99% случаев. А еще он прост в освоении.

- Screaming Frog – мощный инструмент для SEO-cпециалистов, позволяющий собрать кучу полезных данных и провести аудит ресурса (найти сломанные ссылки, структуру данных и т.п.). Можно анализировать до 500 ссылок бесплатно.

- Netspeak Spider – еще один популярный продукт, осуществляющий автоматический парсинг сайтов и помогающий проводить SEO-аудит.

Это наиболее востребованные утилиты для парсинга. У каждого из них есть демо-версия для проверки возможностей до приобретения. Бесплатные решения заметно хуже по качеству и часто уступают даже облачным сервисам.

В виде браузерных расширений

Это самый удобный вариант, но при этом наименее функциональный. Расширения хороши тем, что позволяют начать парсинг прямо из браузера, находясь на странице, откуда надо вытащить данные. Не приходится вводить часть параметров вручную.

Но дополнения к браузерам не имеют таких возможностей, как десктопные приложения. Ввиду отсутствия тех же ресурсов, что могут использовать программы для ПК, расширения не могут собирать такие огромные объемы данных.

Но для быстрого анализа данных и экспорта небольшого количества информации в XML такие дополнения подойдут.

Наиболее популярные расширения-парсеры

- Parsers – плагин для извлечения HTML-данных с веб-страниц и импорта их в формат XML или JSON. Расширение запускается на одной странице, автоматически разыскивает похожие страницы и собирает с них аналогичные данные.

- Scraper – собирает информацию в автоматическом режиме, но ограничивает количество собираемых данных.

- Data Scraper – дополнение, в автоматическом режиме собирающее данные со страницы и экспортирующее их в Excel-таблицу. До 500 веб-страниц можно отсканировать бесплатно. За большее количество придется ежемесячно платить.

- kimono – расширение, превращающее любую страницу в структурированное API для извлечения необходимых данных.

Авторизируйте пользователя так, чтобы он оставался на той же странице

Авторизация на сайте — это важная функция, и пользователи захотят иметь возможность авторизоваться с любой странички на сайте. Так что не забудьте сделать так, чтобы после входа на сайт пользователь попал на ту же страничку, с которой он авторизовывался. Это сделает процесс проще и поможет пользователю сразу приступить к решению своей задачи на сайте.

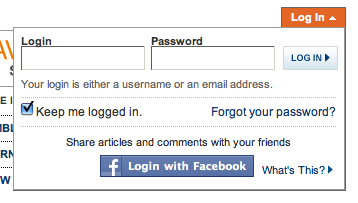

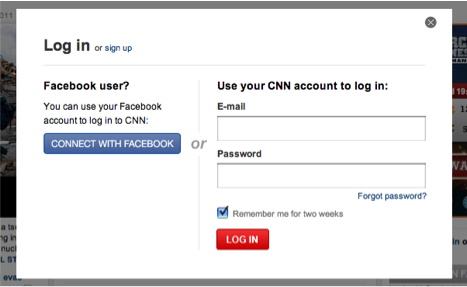

Существует два пути реализации такого процесса: выпадающая форма и модальное окно.

Выпадающая форма открывается, не унося пользователя с текущей страницы. Она занимает только небольшую область на странице, что позволяет сделать форму в таком варианте быстрым и ненагруженным решением.

Модальное окно также не уносит пользователя с текущей страницы — оно разворачивается по центру страницы, концентрируя внимание полностью на форме авторизации. Этот вариант дает возможность разместить в форме дополнительную информацию

Софт для таргета по парсингу аудитории. Пошаговое руководство по парсингу аудитории в соцсетях

Перед поиском аудитории для таргетированной рекламы подумайте, кому и зачем может понадобиться ваш товар или услуга. Это поможет понять, кто теоретически является клиентом, какие выгоды содержит предложение и какие условия могут препятствовать конверсии. Реклама, направленная не на ЦА, окажется бесполезной и обернется «сливом бюджета». И наоборот – зная своих потенциальных клиентов, вы потратите меньше средств на продвижение, но получите больший профит. Итак, начнем.

#1 Составляем портрет нужной целевой аудитории

Под целевой аудиторией подразумевается группа людей, объединенная общими признаками – характеристиками, интересами, потребностями. В маркетинговой стратегии это люди, которым теоретически интересно ваше предложение.

Чтобы составить портрет целевой аудитории, вам нужно максимально подробно описать образ вашего клиента:

- возраст;

- пол;

- место проживания;

- профессиональная деятельность;

- увлечения;

- интересы;

- уровень дохода и прочее.

Чем точнее вы определите образ клиента, тем больше шансов на эффективность рекламной кампании.

Совет! Возможно, что ваш товар интересен сразу нескольким группам покупателей. Но эти группы различаются по своим характеристикам. Не «лепите» все в одну кучу, пытаясь создать средневзвешенный клиентский образ. В подобной ситуации лучше создайте несколько категорий ЦА, поскольку рекламное предложение для них может быть разным. При запуске рекламной кампании сразу на несколько отличающихся категорий потребителей вы рискуете потратить часть бюджета впустую.

Составив портрет ЦА, подумайте, что может интересовать ваших клиентов и где они могут присутствовать: в каких социальных сообществах. Допустим, что по итогам «мозгового штурма» предполагается, что наше предложение будет интересно замужним женщинам 30-35 лет, проживающим в Самаре. После определения ЦА можно приступать к парсингу.

# 2 Парсим аудиторию для таргетированной рекламы в соцсетях

Парсить мы будем на с помощью сервиса Pepper ninja . Он может искать аудиторию по параметрам, статусам, мероприятиям, родственным связям, месту проживания и т. д. Этот платный парсер с бесплатным трехдневным периодом ищет аудиторию в Instagram, ВКонтакте, Одноклассники, Facebook.

Для начала регистрируемся в сервисе и подтверждаем регистрацию через электронную почту. Кстати, сразу после регистрации вы получите пошаговую инструкцию, как искать нужную аудиторию. Если вы совсем новичок, то с помощью этих рекомендаций и подсказок внутри сервиса вы легко справитесь самостоятельно.

Если вы смутно представляете, какой должна быть ваша ЦА, используйте функцию «Кто мой клиент». Это фильтр, который самостоятельно проанализирует аудиторию, соберет готовую базу для таргетинга и найдет сообщества с потенциальными клиентами.

В нашем примере мы знаем своих потенциальных клиентов и планируем запуск рекламной кампании ВКонтакте. Начинаем парсить:

- Поскольку мы ищем аудиторию ВК, выбираем соответствующий раздел.

Подборка сервисов для парсинга

Человечество уже давно придумало все за нас, в том числе и парсинг аудитории. Вам не нужно перебирать всех пользователей в Инстаграм, отбирая нужных пользователей. Онлайн-сервисы сделают это за вас:

- Zengram. Этот сайт очень популярен у тех, кто предпочитает пользоваться не совсем «чистыми» способами продвижения. Такой популярностью Зенграм обязан двум характеристикам: невысокая цена и доступ к нескольким полезным инструментам. Один из таких модулей – парсер. Отбирает страницы по хэштегам, геометкам и фолловерам конкурента. К слову, заодно Zengram может собрать контактные данные, ссылки на сайт и Био.

- Instaplus.me. Ещё один сервис комплексного продвижения. В общем-то, в плане парсинга он не очень отличается от предыдущего, поэтому больше мне сказать нечего.

- Tooligram. Реализован он и как онлайн-сервис и как программа, опять же, для раскрутки. Пожалуй, только этим он отличается от предыдущих вариантов. Программа имеет дополнительный плюс — дополнительная безопасность, ведь ваши данные остаются только на компьютере. Поэтому риск того, что их перехватят злоумышленники, меньше.

Аудитория в Instagram – показатель популярности и коммуникабельности. А сейчас популярность может приносить деньги. Но бездумное продвижение будет крайне медленным, по скорости примерно сравнится с обычным сарафанным радио. Поэтому нужно понимать, как раскрутка работает и как следует простроить стратегию набора подписчиков. Один из самых удобных помощников в этом нелёгком деле является парсинг пользователей в Инстаграм.

Api ключ

Большинство API требуют авторизации ключом API, чтобы использовать API. Ключ API представляет собой длинную строку, которую обычно включают либо в URL запроса, либо в заголовок запроса. Ключ API в основном служит способом идентификации лица, выполняющего запрос API (аутентифицируя для использования API). Ключ API также может быть связан с конкретным приложением, которое регистрируется.

Ключи APK используют строку в свойстве заголовка для авторизации запросов

API могут дать как открытый, так и закрытый ключ. Открытый ключ обычно включается в запрос, в то время как закрытый ключ рассматривается скорее как пароль и используется только при обмене данными между серверами. На некоторых сайтах документации API, при заходе на сайт, ключ API автоматически заполняется в примере кода и API Explorer.

5 сервисов для парсинга аудитории в социальных сетях. Топ-17 парсеров в Инстаграм

Парсеры – это инструменты, с помощью которых можно найти и сегментировать аудиторию, являющуюся для вас целевой. В дальнейшем, с этой аудиторией можно взаимодействовать, проявляя социальную активность: комментируя посты, подписываясь на аккаунты, проставляя лайки и так далее.

Парсинг происходит по заданным вами параметрам: локациям, интересам пользователей, спискам подписчиков ваших конкурентов, событиям и другим настройкам. В этой статье подробно рассмотрим ТОП-17 лучших сервисов для сбора аудитории в Инстаграм.

До +25% к бюджету с getUNIQ

Рекомендуем: getUNIQ – пополняй рекламные кабинеты с выгодой!

- Обещанный платеж

- Единый кабинет и пополнение без комиссий

- Автоматизация, создание и ведение рекламных кампаний во всех сетях

- Настроим рекламу с нуля в Яндекс.Директ, myTarget, VK, TikTok и других сетях

- Наглядная статистика, Автопостинг и Автопополнение

Перейти на сайт

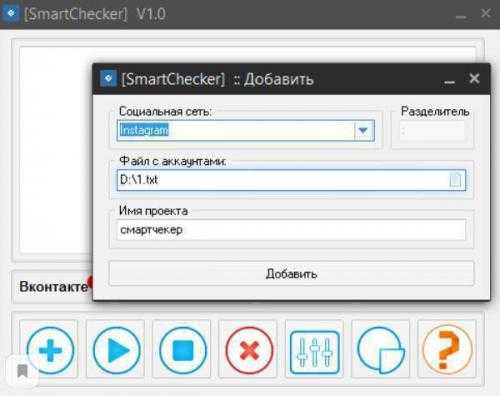

SmartChecker

«» предназначен для сбора данных заданной аудитории. То есть, сам список аккаунтов должен уже быть собран заранее. Можно загрузить в программу текстовый файл с адресами профилей нужных вам пользователей Инстаграма и в итоге получить про них всю необходимую информацию:

- количество постов, подписок и подписчиков, количество лайков;

- личные данные (фамилию, имя, отчество, город проживания и т.д.).

Плюсы

К достоинствам этого парсера можно отнести:

- бесплатное распространение;

- полезный функционал;

- возможность использования в работе прокси.

Для тех, кто желает познакомиться со своей аудиторией поближе и понять, какие у нее преобладают интересы, программа подходит идеально.

Минусы

В качестве минусов можно отметить:

- парсер является софтом, то есть, его нужно скачивать и устанавливать на компьютер;

- не парсит саму аудиторию, а только собирает информацию по готовому списку профилей.

Учитывая, что программа бесплатная, достоинств в ней явно больше, чем недостатков.

Проблематика

Давайте разберемся, какие требования к авторизации встречаются, и почему их крайне важно учитывать изначально при проектировании системы, а не откладывать на будущее. Источников требований к авторизации в корпоративной информационной системе, как правило, два — это бизнес и информационная безопасность

В общем случае бизнес хочет хранить секреты в тайне и предоставлять полномочия пользователям в соответствии с их функцией в бизнес-процессе, а безопасность хочет обеспечить минимальную достаточность полномочий каждому пользователю и аудировать доступ.

Возьмем для примера гипотетическую систему согласования договоров крупной компании, типовой кровавый энтерпрайз. Практически наверняка возникнут следующие требования к авторизации от бизнеса:

- Пользователь, не имеющий отношения к конкретному договору, не должен его видеть в системе

- Автор договора должен видеть его на всех этапах.

- Создавать договор имеет право пользователь с грейдом не ниже 10.

- Визирующий должен видеть договор, начиная с поступления к нему на этап и далее.

- Руководители подразделений должны видеть договоры своих подразделений вверх по иерархии.

- Автор договора и руководитель подразделения имеют право отозвать договор на любом этапе согласования.

- Руководство и секретариат головного офиса должны видеть документы всех филиалов.

- Пользователь, создавший договор, не должен иметь права его завизировать.

От безопасности мы могли бы получить следующие требования

- Знать, кто имеет доступ к конкретному договору.

- Знать, кто имел доступ к конкретному договору в заданный момент времени.

- Лишать пользователя доступа к ранее доступным документам при изменении его должностных обязанностей.

Думаю, разработчикам уже стало страшно :). Дополнительную боль доставляет высокая изменчивость этих требований. Кстати, по статистике одного большого франча 1С – дополнительные требования по авторизации — одна из самых частых задач по кастомизации типовых конфигураций.

Итак, обозначим, почему эти требования проблемные:

Задание №2 — проверка спарсенного урла на футпринты WordPress.

WordPress тяжело детектится по тексту и структуре урлов, но структура папок его выдает с головой.

Поэтому если в исходном коде страницы ресурсы грузятся из папок wp-content и wp-includes, то считайте это WordPress с вероятностью 99.9% , выглядит это примерно так

<link rel='stylesheet' href='https://site.org/wp-content/themes/petlove/css/nivo-slider.css?ver=6.4.2' media='all' /> ... <script src="https://site.org/wp-content/plugins/cookie-law-info/lite/frontend/js/script.min.js?ver=3.1.7" id="cookie-law-info-js"></script> .... <script src="https://site.org//wp-includes/js/jquery/jquery.min.js?ver=3.7.1" id="jquery-core-js"></script>

Поэтому в задании №2 A-Parser зайдет на каждый УРЛ, полученный в задании №1 и проверит есть ли в исходном коде искомый текст или нет.

Сделать это можно используя парсер Net::HTTP вот с такими настройками

Я взял стандартные настройки и

- отключил прокси (1), это опционально, так мы будем ходить на разные сайты, то бана за частые запросы не будет

- добавил фильтр (2), который проверяет код страницы на вхождение строки wp-content/themes, если она отсутствует, то сайт не попадет в результат

- переоопределил результат, нам нужен сайт, который подавали на вход, то есть $query

- сохранил задание в отдельный пресет (4), об этом ниже.

Все, можно подавать данные на вход и проверять, парсинг будет очень быстрый, так как сайты в среднем открываются за пару секунд.

При сборе ТОР10 для трех запросов из Задания №1 из 30 полученных url — осталось 25, я проверил штуки 3 и да — это был WordPress, но тем не менее точность парсинга можно повысить еще выше.

В данном пресете A-Parser ищет просто вхождение в коде странице, а где оно будет — в подключении стилей или просто в тексте — это уже второй вопрос. Для повышения точности я рекомендую использовать несколько фильтров и/или регулярные выражения, например можно добавить такие строки для поиска просто добавив несколько фильтров.

wp-content/themes wp-content/plugins wp-includes/js/ и т.д.

Минус такого подхода — если в момент парсинга сайт будет недоступен, то в базу он тоже не попадет, также сайты с защитой Cloudflare нужно конфигурировать в пресете отдельно.

Что такое парсинг в Инстаграм?

Чтобы понять, что именно парсер анализирует, давайте откроем любую страницу Инстаграм и нажмём правую кнопку мыши. В выпавшем меню найдём пункт «просмотр кода страницы». Кликаем по нему и попадаем на ту же самую страницу, но уже представленную не в виде фотоподборки котят, а в форме кода со ссылками на картинки и кусками текста.

В открывшемся окне видны латинские аббревиатуры, заключённые в символы <,>, или кавычки. Первые называются тегами, и они сообщают тип элемента, например, <,a>, является ссылкой, <,h1>, – заголовокм, а <,p>, – абзацем. Вторые являются атрибутами, в них находится информация об уникальных свойствах каждого объекта.

Как видно, в коде имеется вся информация о том, что отображено на странице. Вот именно это парсер читает и анализирует. Происходит данный процесс с помощью специальных серверных языков программирования и библиотек.

Мобильные прокси для A-Parser: зачем нужны и где купить?

Но прежде, чем скачивать программу A-Parser необходимо понимать, что любые многопоточные и многозадачные действия, идущие с одного IP-адреса будут идентифицированы поисковыми системами и риск применения санкций в виде блокировки очень высокий. Чтобы избежать этого и выполняется подключение к программе мобильных прокси. Это одно из самых простых и надежных решений, позволяющих обеспечить анонимность и безопасность работы в сети, обхождение региональных блокировок, а также бана со стороны поисковиков.

Вот только для работы необходимо использовать качественные и функциональные мобильные прокси. Такой продукт по выгодной цене предлагает сервис MobileProxy.Space. За вполне разумные деньги вы получаете:

- приватный канал с неограниченным трафиком: им будете пользоваться только вы;

- возможность автоматической смены IP-адреса по таймеру: периодичность смены пользователь задает самостоятельно в интервале от 2-х минут до 1-го часа;

- возможность самостоятельно менять IP-адреса по мере необходимости при помощи GET запросов к API;

- одновременная работа с протоколами HTTP(S) и Socks5 по двум параллельно подключенным портам;

- возможность быстрой смены ГЕО и оператора сотовой сети;

- возможность привязать IP без обязательной авторизации.

С такими мобильными прокси ваши возможности парсинга с программой A-Parser будут неограниченными. Воспользуйтесь предложением и убедитесь в этом лично.

Узнать SEO показатели сайтов

С помощью парсера можно узнать многие SEO показатели сайта для его анализа, вместо сбора данных вручную с десятков специализированных сервисов. На сайте можно ознакомиться со всеми SEO метриками, которые собирает A-Parser. Помимо основных данных из поисковых систем, описанных выше, можно узнать метрики из сервисов Alexa, Ahrefs, MOZ, SEMrush, Majestic, LinkPad и других:

- Парсер Alexa Rank собирает позицию сайта в глобальном рейтинге, из какой страны идет больше всего трафика на сайт, позицию сайта в рейтинге этой страны и количество обратных ссылок;

- Парсер MOZ.com покажет популярную метрику DA (Domain Authority) — авторитет домена, рейтинг ключевых слов, оценку уровня спама, ТОП конкурентов, метрику PA (Page Authority – авторитет отдельной страницы сайта) и множество других метрик;

- Парсер LinkPad собирает подробнейшую статистику по количеству обратных ссылок;

- Парсер ahrefs.com собирает Ahrefs rank, количество обратных ссылок и процент dofollow ссылок из них, ТОП 100 обратных ссылок с описанием каждой, ТОП 5 анкоров и страниц;

- Парсер SEMrush выполняет сбор количества обратных ссылок (follow, nofollow), ссылающихся доменов и IP адресов, страницы, находящиеся в индексе Google;

- Парсер сервиса Majestic также возвращает статистику по беклинкам, общее кол-во проиндексированных страниц и популярные показатели сайта Trust Flow (TF) и Citation Flow (CF);

- Парсер MuStat получает данные о количестве посетителей сайта в день, стоимости сайта в USD и рейтинг домена.

- Проверка сайта в чёрных списках Google Safe Browsing и Yandex Safe Browsing;

- Парсер ИКС сайта (индекс качества сайта в Яндекс);

- Парсер Whois покажет дату создания и окончания срока регистрации домена, NS сервера и прочее;

- С помощью Rank::CMS можно определить более 600 видов CMS сайта по признакам.

Задание №1 — парсинг WordPress по футпринтам

Я не стану останавливаться подробно по поводу подбора футпринтов для WordPress при парсинге, так как материал не совсем про это, поэтому я взял самый простой футпринт «Powered by WordPress» и создал обычное задание для парсинга Google.

Мой пресет парсера main (1) это стандартный default, только в подключенными проксями, антикапчей и т.д. т.е. никаких особенных настроек там нету.

А вот чтоб не дописывать каждый раз к запросу футпринт, я использовал переопределение запроса (2), подробнее об этом

Чтоб на выходе получать только корневой URL, я применил к результату регулярное выражение (3), которое его извлекает и записывает в новый массив $result, который потом и выводится (4)

Также на скрин не влезла включенная галочка «Опции: уник по строке», чтоб не получать дубликаты в результате.

При таком подходе пропустятся все WordPress которые находятся в папках, т.е. site.com/blog, но такие ситуации крайне редки, зато результат задания №2 не будет содержать дублей по доменам.

Запустив этот пресет на сбор ТОР10, мы получим ссылки главные страницы сайтов, которые могут быть WordPress, а могут быть и нет, их фильтрация будет сделана на следующем этапе.

Что такое парсинг и для чего он нужен в продвижении

Для того, чтобы пользователи не выполняли множество работы по поиску клиентов, сбору, систематизации информации о подписчиках в социальной сети, создано программное обеспечение, выполняющее все эти функции. Парсинг собирает аудиторию, экономя время и силы на ее поиск. Владелец страницы получает точную информацию, снижается вероятность человеческого фактора и неверного проведения расчетов.

Программы – инструменты, устанавливающиеся на компьютер или отдельные сайты, автоматизирующие ручную работу, постоянные занятия одним и тем же делом. Парсеры считаются помощниками в раскрутке профиля, без которых невозможна качественная работа.

Зачем нужны парсеры

Парсер — это программа, сервис или скрипт, который собирает данные с указанных веб-ресурсов, анализирует их и выдает в нужном формате.

С помощью парсеров можно делать много полезных задач:

Для справки. Есть еще серый парсинг. Сюда относится скачивание контента конкурентов или сайтов целиком. Или сбор контактных данных с агрегаторов и сервисов по типу Яндекс.Карт или 2Гис (для спам-рассылок и звонков). Но мы будем говорить только о белом парсинге, из-за которого у вас не будет проблем.

Где взять парсер под свои задачи

Есть несколько вариантов:

- Оптимальный — если в штате есть программист (а еще лучше — несколько программистов). Поставьте задачу, опишите требования и получите готовый инструмент, заточенный конкретно под ваши задачи. Инструмент можно будет донастраивать и улучшать при необходимости.

- Воспользоваться готовыми облачными парсерами (есть как бесплатные, так и платные сервисы).

- Десктопные парсеры — как правило, программы с мощным функционалом и возможностью гибкой настройки. Но почти все — платные.

- Заказать разработку парсера «под себя» у компаний, специализирующихся на разработке (этот вариант явно не для желающих сэкономить).

Первый вариант подойдет далеко не всем, а последний вариант может оказаться слишком дорогим.

Что касается готовых решений, их достаточно много, и если вы раньше не сталкивались с парсингом, может быть сложно выбрать. Чтобы упростить выбор, мы сделали подборку самых популярных и удобных парсеров.

Законно ли парсить данные?

В законодательстве РФ нет запрета на сбор открытой информации в интернете. Право свободно искать и распространять информацию любым законным способом закреплено в четвертом пункте 29 статьи Конституции.

Допустим, вам нужно спарсить цены с сайта конкурента. Эта информация есть в открытом доступе, вы можете сами зайти на сайт, посмотреть и вручную записать цену каждого товара. А с помощью парсинга вы делаете фактически то же самое, только автоматизированно.