Key collector аналоги. Топ-10 сервисов и программ для парсинга

Парсинг данных стал неотъемлемой частью работы маркетологов, SEO-специалистов, SMM и контент-менеджеров, позволяющий получать доступ к постоянно актуальным данным и качественно использовать их в своих целях.

Приложения и сервисы для парсинга

В сети Интернет можно найти большое количество софта для сбора данных, доступны как бесплатные, так и платные, более продвинутые варианты, которые можно устанавливать на свои устройства или получить доступ онлайн через веб-браузеры. Компания Proxy-Seller выбрала топ-10 популярных программ и сервисов для парсинга, с их помощью всегда можно получить желаемый результат.

Screaming Frog что это

Screaming Frog Seo Spider являет собой программу на основе xPath, созданную для настраиваемого парсинга и обширного аудита сайтов. Она по праву считается эталоном по сбору данных и аналитике

Несмотря на громоздкий интерфейс отлично структурировано меню, пользователи всегда смогут легко и быстро получить доступ к важной информации

Screaming Frog владеет следующими возможностями:

Парсинг данных сайтов;

Глубокий аудит SEO-показателей веб-страниц;

Сбор метаданных и заголовков;

Мониторинг рабочих и нерабочих ссылок;

Работа с sitemap и robot.txt;

Поддержка прокси, 500 адресов в бесплатной версии и неограниченное (зависит от количества прокси) в платной;

Детальные уроки и документация.

Софт совместим с операционными системами Windows, MacOS, Ubuntu.

Scraper API

Если вы владеете одним из популярных языков программирования под Интернет (PHP, Python, Ruby или NodeJS), то данный онлайн сервис отлично подойдет вам для решения задач связанных с парсингом данных. Одним из преимуществ в виде быстрого сбора информации, является неограниченное использование в Scraper API прокси.

Возможности Scraper API:

Поддержка одновременно до 40 млн IP адресов;

Дюжина удобных геолокаций;

Поддержка Java Script;

Автоматический обход капчи;

Не лимитированная пропускная способность.

Key Collector

Программа создана, как инструмент для организации семантического ядра, автоматизации рутинных процессов парсинга и подготовки отчетов по самым эффективным поисковым запросам. Приватные прокси сервера для Key Collector, которые можно купить на сайте компании Proxy-Seller, позволяют существенно минимизировать время на сбор данных.

Функции Key Collector:

Автоматический сбор фраз, присутствует возможность настроить 50 разных параметров и одновременно использовать 30 источников информации;

Использование множества фильтров и систем анализа для получения лучших запросов;

Структурирование и маркировка групп для создания сложных проектов;

Семантическое ядро Key Collector позволяет удобно работать с данными без необходимости разбивать их на множество маленьких файлов;

Анализ групп в автоматическом режиме;

Поиск явных и неявных дублей.

Приложение совместимо со всеми представителями семейства Windows начиная с седьмой версии. Для работы требуется установка пакетов .NET Framework 4.8 и Microsoft Visual C++ (версии Redistributable for Visual Studio 2015, 2017 и 2019).

SpyWords

SpyWords — это онлайн инструмент (сервис) для контент-менеджеров, SEO-специалистов и интернет-маркетологов. Основное предназначение поиск ключевых слов и запросов на сайтах конкурентов и в поисковых системах. Среди возможностей SpyWords следует отметить:

Быстрый и качественный анализ сайтов;

Сбор, создание и получение семантического ядра;

Поиск запросов с максимальным трафиком в конкурентов;

Определение позиций сайта в поисковых системах по заранее заданным запросам;

Сбор запросов в контекстной рекламе;

Комплексная оптимизация SEO;

Автоматический расчет бюджета на основе собранных данных.

Keys.so

Сервис специализируется на парсинге поисковых запросов и ключевых слов конкурентов с последующим структурированием данных, проведение автоматического анализа и отбора важной информации. Он поможет выделить максимально эффективную стратегию для привлечения трафика

Среди преимуществ Keys.so выделяют:

Тарифные планы ODDSCORP

Ценовая политика не относится к категории “слишком дешевые”, однако и чрезвычайно дорогими тарифы назвать нельзя. Базовая стоимость с подключением одной букмекерской компании — 150 евро в месяц. Если же контор нужно присоединить более 5, а срок использования сервиса превышает 3 и более месяца, то ODDSCORPпредоставляет хорошие скидки, вплоть до 60%. Максимальное снижение цены осуществляется на лучший пакет, который состоит из всевозможных предложений с включением всех букмекеров и подпиской на год.

Тарифы сервиса ODDSCORP:

- сканер вилок для Прематча/Live/Комплекта Прематч+Live — 100/150/225 €;

- сканер валуев (value) — 500 €;

- обновление коэффициентов для Прематча/Live/Комплекта Прематч+Live — 250/250/400 €.

Если проанализировать возможности, то наблюдается полное соответствие цены-качества. Функционал ODDSCORP первоклассного уровня: высокая скорость получения данных, API, быстрое обновление, множество известных букмекеров и рынков.

Дополнительное преимущество — внедрить API сможет любой, кто знаком с такими языками программирования, как PHP, Python, JavaScript, C#. Даже новички в IT могут справиться с этим, но если не выходит, лучше обратиться к профессионалам. Каждое решение сопровождается специальной документацией и детальной инструкцией по внедрению, потому интеграция пройдет без проблем. Любые файлы стоит скачивать исключительно с официального сайта. Только на главной платформе представлены проверенные разработки, без вирусов и хакерского кода.

Чек-лист по выбору парсера

Краткий чек-лист, который поможет выбрать наиболее подходящий инструмент или сервис.

- Четко определите, для каких задач вам нужен парсер: анализ SEO конкурентов или мониторинг цен, сбор данных для наполнения каталога, съем позиций и т.д.

- Определите, какой объем данных и в каком виде нужно получать.

- Определите, как часто вам нужно собирать данные: единоразово или с определенной периодичностью (раз в день/неделю/месяц).

- Выберите несколько инструментов, которые подходят для решения ваших задач. Попробуйте демо-версии. Узнайте, предоставляется ли техническая поддержка (желательно даже протестировать ее — задать парочку вопросов и посмотреть, как быстро вы получите ответ и насколько он будет исчерпывающим).

- Выберите наиболее подходящий сервис по соотношению цена/качество.

Для крупных проектов, где требуется парсить большие объемы данных и производить сложную обработку, более выгодной может оказаться разработка собственного парсера под конкретные задачи.

Для большинства же проектов достаточно будет стандартных решений (возможно, вам может быть достаточно бесплатной версии любого из парсеров или пробного периода).

Виды парсеров по сферам применения

Для организаторов СП (совместных покупок)

Есть специализированные парсеры для организаторов совместных покупок (СП). Их устанавливают на свои сайты производители товаров (например, одежды). И любой желающий может прямо на сайте воспользоваться парсером и выгрузить весь ассортимент.

Чем удобны эти парсеры:

- интуитивно понятный интерфейс;

- возможность выгружать отдельные товары, разделы или весь каталог;

- можно выгружать данные в удобном формате. Например, в Облачном парсере доступно большое количество форматов выгрузки, кроме стандартных XLSX и CSV: адаптированный прайс для Tiu.ru, выгрузка для Яндекс.Маркета и т. д.

Популярные парсеры для СП:

- SPparser.ru,

- Облачный парсер,

- Турбо.Парсер,

- PARSER.PLUS,

- Q-Parser.

Вот три таких инструмента:

- Marketparser,

- Xmldatafeed,

- ALL RIVAL.

Парсеры для быстрого наполнения сайтов

Такие сервисы собирают названия товаров, описания, цены, изображения и другие данные с сайтов-доноров. Затем выгружают их в файл или сразу загружают на ваш сайт. Это существенно ускоряет работу по наполнению сайта и экономят массу времени, которое вы потратили бы на ручное наполнение.

В подобных парсерах можно автоматически добавлять свою наценку (например, если вы парсите данные с сайта поставщика с оптовыми ценами). Также можно настраивать автоматический сбор или обновление данных по расписания.

Примеры таких парсеров:

- Catalogloader,

- Xmldatafeed,

- Диггернаут.

ТОП-7 парсеров для сбора поисковых подсказок. Парсер поисковых подсказок, сервис Раш Аналитикс (Rush Analytics)

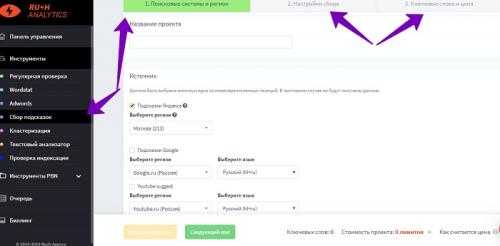

Сервис Раш Аналитикс осуществляет быстрый парсер поисковых подсказок в Яндексе и Гугле. На нём также нужно зарегистрироваться и подтвердить свою учётную запись. Далее, заходим в левую часть панели управления сервиса – «Сбор подсказок» и создаём там «Новый проект». (Скрин 4).

Затем, кликаем по кнопке «Следующий шаг» и заполняем настройки другого раздела – «Настройка сбора». В нём лишь нужно оставить две галочки перед параметрами – «Ключевое слово» или установить по желанию другие параметры. После всех изменений нажимаем на «Следующий шаг» и попадаем в другой раздел – «Ключевые слова и цена».

Там где раздел «Списком» прописываем ключевые слова. И нажимаем кнопку «Добавить ключевые слова»

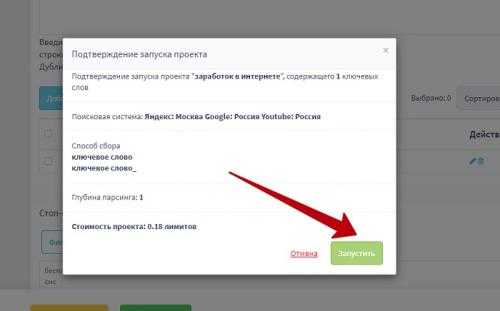

Затем, очень важно нажать на «Создать проект», чтобы запустить процесс сбора ключевых слов (Скрин 5)

Когда парсер ключевых слов будет закончен, Вы сможете скачать готовые ключи, или посмотреть их на сервисе. Обычно формат таких файлов скачивается на компьютер в виде Эксель таблицы, что очень удобно.

Преимущество сбора подсказок в Раш Аналитикс

Стоит рассказать о самых главных преимуществах сбора подсказок на сервисе Rush-analytics. Они действительно помогут Вам продвинуть блог, сайт и раскрутить статьи:

- Ненужные поисковые запросы удаляются. Алгоритм данного сервиса отслеживает и удаляет те подсказки во время сбора, которые не приносят трафика. И оставляют в базе подсказок самый топ поисковых ключей.

- Можно установить любой регион и язык. Раш Аналитикс поддерживает любые иностранные языки для поиска, и настраивает все регионы. Например, Москва, Ульяновская область и другие.

- Глубокое исследовании ниши. Сервис очень глубоко исследует нишу Вашего бизнеса, и поэтому после сбора подсказок можно получить в результате популярные ключевые слова.

Эти преимущества, дают понять что этот сервис стоит использовать для продвижения статей, несмотря на то, что он платный.

Арсенкин Евгений Юрьевич: в каких юридических лицах значится

Согласно данным Единого государственного реестра юридических лиц (ЕРГЮЛ) от 09.11.2022, публикуемым налоговой службой РФ, Арсенкин Евгений Юрьевич (ИНН 633004708684 ) упоминается в следующих юридических лицах.

Данный ИНН был выдан налоговой инспекцией региона Самарская область .

Организации, в отношении которых упоминается данное лицо, зарегистрированы в регионе Самарская область (аренда и лизинг грузовых транспортных средств; выращивание однолетних культур).

Ранее Арсенкин Е. Ю. значился в сведениях об организации, зарегистрированной в регионе Самарская область: оптовая торговля прочим жидким и газообразным топливом.

Руководитель, директор

До 25 декабря 2013 г.Арсенкин Е. Ю. был руководителем (лицом, имеющим право без доверенности действовать от имени юридического лица).

Арсенкин Е. Ю. является учредителем в организациях:

- ООО «КОРОВКИНО»

Арсенкин Евгений Юрьевич и опосредованно связанные лица

По данным, содержащимся в ЕГРЮЛ, прослеживаются следующие косвенные связи лица с российскими организациями, их руководителями, учредителями

Обращаем внимание, что связи могут носить формальный характер и не обязательно свидетельствуют о реальных контактах указанных лиц. При установлении связи учитывалось совпадение не только фамилии, имени и отчества, но и ИНН физического лица

Справочная сводка сведений о сервисе ODDSCORP

Разработчики уже более 5 лет занимаются созданием различных профессиональных проектов для беттинга. В команде работают профессионалы своего дела, что закономерно сказывается на результатах. Надо констатировать тот факт, что ODDSCORP имеет безупречную репутацию и разработчики не собираются останавливаться на достигнутом и считают своей миссией дальнейшее развитие проекта.

Интересный факт — проводится создание дефляционного тренда, путем организации закрытого клуба с ограниченным количеством клиентов. Разработчики решили принять в клуб не более 500 участников, с течением времени это скажется на увеличении объема заработка участниками. На момент написания данной статьи, к проекту присоединилось 375 игроков. Не трудно подсчитать, что осталось 125 свободных мест. Пока еще достаточно.

Ну и конечно же возможно получить дивиденды за эффективный анализ коэффициентов: вилки, валуи, плюсовые коридоры, основанные на их основе

Прекрасные условия, но важно помнить, что после регистрации 500-го активного аккаунта, создать новую учетную запись будет невозможно, и разработчики не планируют увеличивать количество слотов для вступления в закрытый клуб

Виды парсеров по технологии

Браузерные расширения

Для парсинга данных есть много браузерных расширений, которые собирают нужные данные из исходного кода страниц и позволяют сохранять в удобном формате (например, в XML или XLSX).

Парсеры-расширения — хороший вариант, если вам нужно собирать небольшие объемы данных (с одной или парочки страниц). Вот популярные парсеры для Google Chrome:

- Parsers;

- Scraper;

- Data Scraper;

- Kimono.

Надстройки для Excel

Программное обеспечение в виде надстройки для Microsoft Excel. Например, ParserOK. В подобных парсерах используются макросы — результаты парсинга сразу выгружаются в XLS или CSV.

Google Таблицы

С помощью двух несложных формул и Google Таблицы можно собирать любые данные с сайтов бесплатно.

Эти формулы: IMPORTXML и IMPORTHTML.

IMPORTXML

Функция использует язык запросов XPath и позволяет парсить данные с XML-фидов, HTML-страниц и других источников.

Вот так выглядит функция:

Функция принимает два значения:

- ссылку на страницу или фид, из которого нужно получить данные;

- второе значение — XPath-запрос (специальный запрос, который указывает, какой именно элемент с данными нужно спарсить).

Хорошая новость в том, что вам не обязательно изучать синтаксис XPath-запросов. Чтобы получить XPath-запрос для элемента с данными, нужно открыть инструменты разработчика в браузере, кликнуть правой кнопкой мыши по нужному элементу и выбрать: Копировать → Копировать XPath.

С помощью IMPORTXML можно собирать практически любые данные с html-страниц: заголовки, описания, мета-теги, цены и т.д.

IMPORTHTML

У этой функции меньше возможностей — с ее помощью можно собрать данные из таблиц или списков на странице. Вот пример функции IMPORTHTML:

Она принимает три значения:

- Ссылку на страницу, с которой необходимо собрать данные.

- Параметр элемента, который содержит нужные данные. Если хотите собрать информацию из таблицы, укажите «table». Для парсинга списков — параметр «list».

- Число — порядковый номер элемента в коде страницы.

Зачем нужны парсеры

Парсер — это программа, сервис или скрипт, который собирает данные с указанных веб-ресурсов, анализирует их и выдает в нужном формате.

С помощью парсеров можно делать много полезных задач:

Для справки. Есть еще серый парсинг. Сюда относится скачивание контента конкурентов или сайтов целиком. Или сбор контактных данных с агрегаторов и сервисов по типу Яндекс.Карт или 2Гис (для спам-рассылок и звонков). Но мы будем говорить только о белом парсинге, из-за которого у вас не будет проблем.

Где взять парсер под свои задачи

Есть несколько вариантов:

- Оптимальный — если в штате есть программист (а еще лучше — несколько программистов). Поставьте задачу, опишите требования и получите готовый инструмент, заточенный конкретно под ваши задачи. Инструмент можно будет донастраивать и улучшать при необходимости.

- Воспользоваться готовыми облачными парсерами (есть как бесплатные, так и платные сервисы).

- Десктопные парсеры — как правило, программы с мощным функционалом и возможностью гибкой настройки. Но почти все — платные.

- Заказать разработку парсера «под себя» у компаний, специализирующихся на разработке (этот вариант явно не для желающих сэкономить).

Первый вариант подойдет далеко не всем, а последний вариант может оказаться слишком дорогим.

Что касается готовых решений, их достаточно много, и если вы раньше не сталкивались с парсингом, может быть сложно выбрать. Чтобы упростить выбор, мы сделали подборку самых популярных и удобных парсеров.

Законно ли парсить данные?

В законодательстве РФ нет запрета на сбор открытой информации в интернете. Право свободно искать и распространять информацию любым законным способом закреплено в четвертом пункте 29 статьи Конституции.

Допустим, вам нужно спарсить цены с сайта конкурента. Эта информация есть в открытом доступе, вы можете сами зайти на сайт, посмотреть и вручную записать цену каждого товара. А с помощью парсинга вы делаете фактически то же самое, только автоматизированно.

Преимущества проекта ODDSCORP

Среди основных целей проекта ODDSCORP — стать одним из лидеров на мировом рынке по сбору, анализу и продаже сведений в области беттинга. Также разработчики не скрывают, что есть желание стабильно поддерживать клиентов проверенной информацией и анализом данных с букмекерской конторы, тем самым увеличивая их прибыль со ставок.

В условиях растущего беттингового рынка, как в масштабе России, так и в мире, эта цель выглядит амбициозной, но и вполне достижимой: заявка на лидерство уже де-факто подана.

Главные преимущества проекта:

разработчики создали одно из лучших браузерных расширений BetMAX — софт способен находить лучшие коэффициенты на основе парсинга линий известных букмекерских компаний;

база данных и WS/HTTP-сервера разработана с нуля, причем на самом низком уровне, без использования apache, nginx и SQL;

измеряются все внутренние процессы, чтобы контролировать выполнение кода — среднее время обработки для API: 0,0025 секунд;

общая производительность оборудования составляет 812 ядер с мощностью 2404 GHz, которого предостаточно для выполнения даже самых сложных операций — центральный вычислительный сервер 4xXeon Platinum 8269 обеспечивает идеальную производительность и максимально эффективную устойчивость к нагрузкам, что немаловажно в дни большого количества спортивных событий;

сканер обрабатывает более 70 известных и популярных букмекерских компаний, осуществляя анализ 25 видов спорта с разными событиями из росписи;

сервис постоянно развивается, и разработчики готовы расширить список букмекерских контор по запросу — идеальный вариант увеличить пул букмекеров любимой платформой, если ее нет в перечне.

Также проект представляет мета-данные для поиска лучших ставок. Эта возможность помогает сократить время почти на 80%, подключив специального бота к новой конторе. В итоге любой прогноз находится буквально за 1-2 строчки JavaScript-кода.

- e-mail сервиса: support@oddscorp.com;

- Telegram: @oddscorp.

Служба поддержки работает круглосуточно и без выходных, потому можно обращаться в любое время суток, чтобы получить ответы на интересующие вопросы.

Десктопные и облачные парсеры

Облачные парсеры

Основное преимущество облачных парсеров — не нужно ничего скачивать и устанавливать на компьютер. Вся работа производится «в облаке», а вы только скачиваете результаты работы алгоритмов. У таких парсеров может быть веб-интерфейс и/или API (полезно, если вы хотите автоматизировать парсинг данных и делать его регулярно).

Например, вот англоязычные облачные парсеры:

- Import.io,

- Mozenda (доступна также десктопная версия парсера),

- Octoparce,

- ParseHub.

Из русскоязычных облачных парсеров можно привести такие:

- Xmldatafeed,

- Диггернаут,

- Catalogloader.

Любой из сервисов, приведенных выше, можно протестировать в бесплатной версии. Правда, этого достаточно только для того, чтобы оценить базовые возможности и познакомиться с функционалом. В бесплатной версии есть ограничения: либо по объему парсинга данных, либо по времени пользования сервисом.

Десктопные парсеры

Большинство десктопных парсеров разработаны под Windows — на macOS их необходимо запускать с виртуальных машин. Также некоторые парсеры имеют портативные версии — можно запускать с флешки или внешнего накопителя.

Популярные десктопные парсеры:

- ParserOK,

- Datacol,

- Screaming Frog, ComparseR, Netpeak Spider — об этих инструментах чуть позже поговорим подробнее.

Парсер поисковых запросов. Решение

Во-первых,

- text — текст поискового запроса. URL-кодированный.

- p — номер страницы выдачи (p=0, 1, 2…). Without comments

- numdoc — число выдаваемых результатов на страницу(numdoc=10, 20, 30, 50; допустимы только эти значения и никакие более). Для анализа позиций сайта по ключевым словам лучше всего юзать наибольшее значение, т.к. явное уменьшение нагрузки на сервер и, как следствие — меньше подозрений, что «Я, робот»

Во-вторых,

#

.*>*tabindex>*onclick>*=>*»>*»>*href=»(«>+)»>*>(.+).*

- preg_match_all(РЕГВЫР, HTML_ВЫДАЧИ, МАССИВ_РЕЗУЛЬТАТОВ, PREG_SET_ORDER);

* This source code was highlighted with Source Code Highlighter .

В итоге,

- получаю первую страницу с выдачей

- если это не «страница недоверия» Яндекса с капчей — прогоняю через регвыр, перебираю результаты в поиске нужного.

- если нахожу, возвращаю результат — номер позиции страницы в выдаче, не нахожу — получаю следующую страницу и возвращаюсь к п.2, подождав секунды 3-5

- resultsLimit — ограничение по глубине поиска, по умолчаниюлюблю ставить 200

- url — имя хоста, который ищем в выдаче. Учитывается любая страница с этого хоста

- keyword — запрос к поисковику.

Абстрактный класс — SomeAnalyzer:

abstractclassSomeAnalyzer{

//// ИНТЕРФЕЙС

// функция анализа

publicabstractfunction analyzeThis($url);

// получение имени хоста из url (parse_url с дополнительным функционалом, поскольку убедился что просто parse_url не всегда почему-то работает, когда url слишком неудобочитаемый)

publicfunction getHost($url){

$url=@parse_url($url);

if($url’path’

$url’host’>=$url’path’>;

$url’host’>=ereg_replace(«/.*$»,«», $url’host’>);

$url’host’>=ereg_replace(«^www\.»,«», $url’host’>);

return$url’host’>;

}

//// РЕАЛИЗАЦИЯ

// функция сравнения 2-х url на предмет принадлежности к одному хосту

protectedfunction compareURL($url1, $url2){

$url1=$this->getHost($url1);

$url2=$this->getHost($url2);

return(strtoupper($url1’host’>)==strtoupper($url2’host’>)?:);

}

}

* This source code was highlighted with Source Code Highlighter .

Итоги битвы парсеров: кто же заслуживает звания короля WordPress плагинов?

Все перечисленные плагины-парсеры имеют свои уникальные особенности и преимущества, и выбор конкретного инструмента зависит от ваших конкретных потребностей и задач.

Если вам требуется мощный и гибкий инструмент для парсинга информации с других сайтов, WP Web Scraper может быть отличным выбором. Он поддерживает большинство селекторов и позволяет настраивать процесс скрейпинга под свои задачи.

WP RSS Aggregator и RSS Post Importer отлично подходят для работы с RSS и Atom лентами, что может быть полезно для новостных сайтов или блогов, где актуальность информации играет важную роль.

Для задач импорта большого количества данных в форматах XML и CSV стоит обратить внимание на Import any XML or CSV File to WordPress. Данный плагин обладает гибкими настройками импорта и поддерживает массовую загрузку файлов

Если ваш сайт связан с электронной коммерцией или агрегацией товаров, Content Egg станет полезным помощником. Он автоматизирует процесс сбора информации о товарах с разных площадок и помогает оформить данные в удобоваримом виде.

CyberSEO Lite и FeedWordPress отлично подойдут для создания автономных новостных агрегаторов, позволяя вам автоматически копировать и вставлять статьи из RSS-лент в ваш блог WordPress.

Плагины Simple HTML DOM и HTML Import 2 полезны при работе с HTML. Они предоставляют удобные средства для парсинга и импорта HTML-контента на ваш сайт.

И наконец, WP Scraper подойдет для тех, кому необходимо копировать веб-сайты и создавать содержимое для вашего WordPress сайта. Этот плагин удобен в использовании и поддерживает визуальное редактирование настроек скрейпинга.

Независимо от выбранного плагина, всегда важно убедиться, что вы соблюдаете законы и нормы, связанные с использованием и распространением контента из Интернета. Помните о правилах и регуляциях, касающихся авторских прав и персональных данных

Для того, чтобы быстро и качественно настроить любой из парсеров – я рекомендую обратится к специалисту-фрилансеру. Большой выбор специалистов представлен на биржах фриланса KWORK и FL. На этих сайтах можно воспользоваться безопасной сделкой, что гарантирует качественное выполнение заказа.