Сниппет в поисковой выдаче Google

Сниппет в поисковой выдаче Google служит той же цели и отличается лишь некоторыми визуальными элементами, которые отображаются в анонсе сайта помимо его описания. Например, цепочку навигации эта поисковая система выводит над заголовком, а не под ним, как в Яндексе. Также описание сайта в Google состоит из двух строк (до 165 символов), тогда как в Яндексе объем текста может быть больше – до 500 знаков.

Как формируются сниппеты в поисковых системах?

Ни в одной поисковой системе нет возможности с точностью проконтролировать, каким будет сниппет. Каждый поисковик строит описание по заданным его разработчиками алгоритмам, которые ими не раскрываются в полной мере. При этом анонсы одной веб-страницы могут различаться в зависимости от запроса пользователя.

Оптимизатор может попытаться лишь косвенно повлиять на формирование сниппета, корректно заполнив seo-значимые теги и внедрив микроразметку. О правильной настройке сниппета мы подробно поговорим ниже.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

Подписаться

Что такое Web Scraping?

Техника сбора и обработки необработанных данных из Интернета известна как парсинг веб-страниц, и сообщество Python разработало несколько довольно мощных инструментов парсинга веб-страниц. А конвейер данных используется для обработки и хранения этих данных в структурированном виде.

Веб-скрапинг сегодня является обычной практикой с многочисленными приложениями:

- Компании, занимающиеся маркетингом и продажами, могут собирать данные о лидах с помощью парсинга веб-страниц.

- Компании, занимающиеся недвижимостью, могут получать информацию о новостройках, выставленных на продажу объектах и т. д., используя веб-скрапинг.

- Веб-сайты сравнения цен, такие как Trivago, часто используют веб-скрапинг для получения данных о продуктах и ценах с разных веб-сайтов электронной коммерции.

Вы можете очистить Интернет, используя различные языки программирования, и каждый язык программирования имеет множество библиотек, которые могут помочь вам выполнить одно и то же. Одной из самых популярных, надежных и законных программ, используемых для эффективного веб-скрейпинга, является Python.

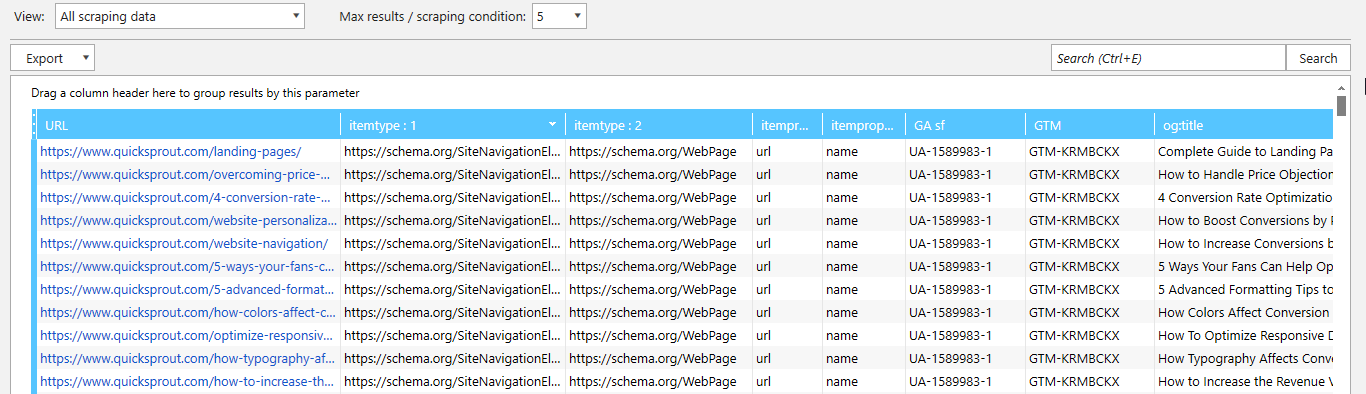

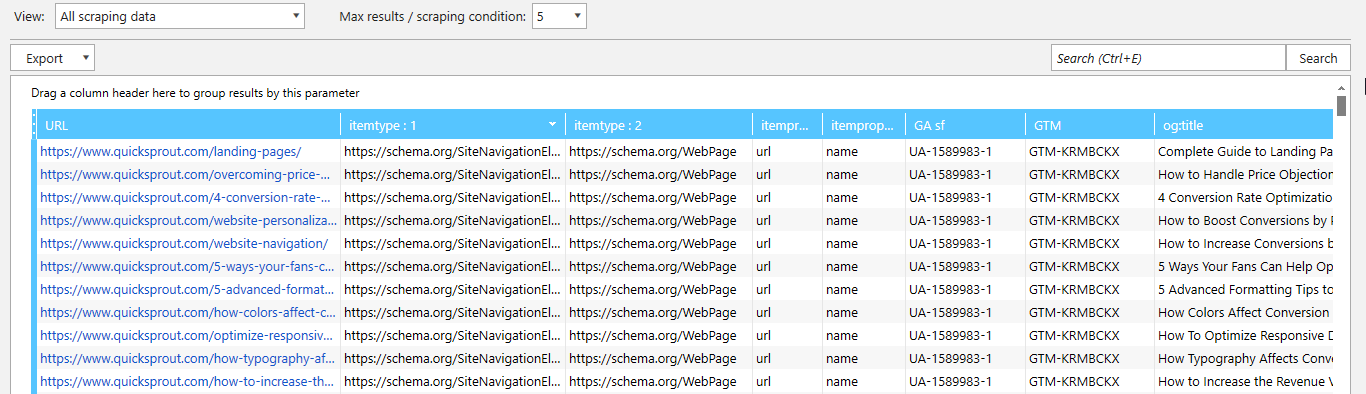

Конкретные части кода на сайтах или отдельных страницах

С помощью парсинга можно реализовать поиск определенных участков кода по списку сайтов для понимания, какие из них пользуются или не пользуются каким-то конкретным функционалом.

Пример парсинга элементов Schema, кода GTM, GA, и OpenGraph с помощью Netpeak Spider

Нужно проверить, какие сайты из списка используют онлайн-чат или другие технологии, присутствующие в исходном коде? С помощью парсинга можно быстро собрать информацию касательно используемых на сайте технологий, скриптов и надстроек.

Микроразметка Schema.org используется для структурирования и передачи информации поисковым системам. Существует более 600 типов Schema для различных нужд. Парсинг структурированных данных позволяет собрать ключевую информацию со страниц сайта. Например, спарсив элементы Organization Schema, можем получить адрес, лого, контактную информацию, и т.д.

Hreflang позволяет настроить мультиязычность и мультирегиональность для интернациональных сайтов. Чтобы проверить правильность постановки тегов на всех страницах сайта, достаточно указать несколько условий парсинга и просканировать сайт.

Нередки случаи, когда из-за неправильного проставления кода GA или GTM возникают проблемы с аналитикой. С помощью парсинга можно проверить наличие кодов на всех страницах сайта и их корректность.

Требования

Чтобы создать парсер Python, вам необходимы:

-

Python 3.4+

-

pip (менеджер пакетов)

Обратите внимание, что pip по умолчанию включен в состав Python версии 3.4 и выше. Поэтому устанавливать его вручную не требуется

Если на вашем компьютере нет Python, следуйте приведенному ниже руководству для вашей операционной системы

macOS

Раньше компьютеры Mac поставлялись с предустановленным Python 2.7, но теперь это уже не так, поскольку эта версия устарела.

Если вам нужна последняя версия Python, ее необходимо установить вручную. Для этого загрузите программу установки, дважды щелкните по ней, чтобы запустить, и следуйте указаниям мастера установки.

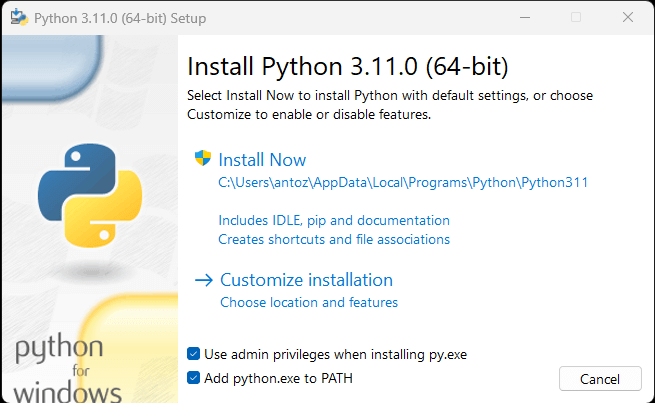

Windows

Загрузите программу установки Python и запустите ее. Во время работы мастера установки убедитесь, что отмечен флажок «Добавить python.exe в PATH», как показано ниже:

Окно установки Python для Windows

Таким образом, Windows будет автоматически распознавать команды python и pip в терминале. Напомним, что pip — менеджер пакетов для Python.

Linux

В большинстве дистрибутивов Linux Python уже предустановлен, однако речь может идти не о самой последней версии. Команда для установки или обновления Python в Linux зависит от менеджера пакетов. В дистрибутивах Linux на базе Debian выполните команду:

Независимо от используемой ОС, откройте терминал и убедитесь, что Python успешно установлен:

В результате должно получиться что-то вроде этого:

Теперь все готово для создания вашего первого парсера Python. Но сначала вам нужна библиотека веб-скрапинга Python!

Как написать контент для избранных сниппетов

Есть несколько способов попытаться полностью нацелиться на избранные сниппеты. В приведенном ниже списке перечислены некоторые нюансы, которые необходимо учитывать при написании «красивых сниппетов»:

- Проведите исследование вашего ключевого слова;

- Узнайте, что люди спрашивают о ваших ключевых словах / бренде / продукте / услуге;

- Посмотрите на «Люди также спрашивают» – для расширения идей;

- Используйте функцию «Ответить на вопросы общественности», чтобы найти вопросы, на которые нужно ответить;

- Проверьте несколько текущих ответов, чтобы увидеть, как это работает;

- Узнайте, где еще вы могли бы что-либо улучшить;

- Определите, как структурировать ваш контент;

- Сделайте ваш контент максимально полезным и легким для понимания;

- Ваши ответы должны быть короткими и быстрыми, не более 50 слов;

- Сделайте статью удобной для Google, чтобы использовать ее (поэтому используйте списки, подзаголовки и т. д.);

- Пометьте свою статью структурированными данными (хотя они вам не всегда нужны);

- Следите за тем, чтобы ваш контент не становился неестественным;

- Не каждый поиск приведет к избранному фрагменту (есть даже территориальные варианты);

В довершение всего найдите способ заставить людей нажимать на избранный сниппет. Не давайте сразу все ответы, но постарайтесь, чтобы люди приходили на ваш сайт и могли получить полную картину.

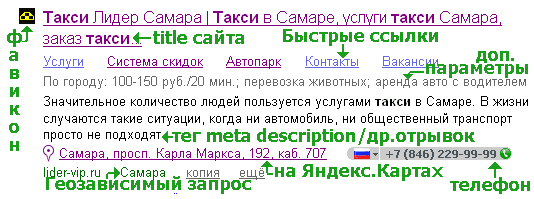

Как формируется сниппет и его составляющие

В независимости от поисковой системы, будь это Яндекс или Google, основа у них одна. Но существуют небольшие различия, например, отображение логотипа сайта, который есть в Яндексе, но нету в гугле.

В независимости от поисковой системы, будь это Яндекс или Google, основа у них одна. Но существуют небольшие различия, например, отображение логотипа сайта, который есть в Яндексе, но нету в гугле.

Однако, следует знать все возможные варианты содержания составляющих, поэтому ниже описано формирование сниппета с дополнительными расширениями.

Использование единственного и множественного числа

Удивительным открытием для меня оказалось то, что для сниппета как для заголовка, так и для описания не имеет разницы в каком числе было написано ключевое слово, в единственном или множественном. К примеру, купить бойлерную для котла или купить бойлерную для котлов – не имеет значение.

Использования частей речи

Не важно какую часть речи вы используете для сниппета, это может быть как глагол, так и существительное. В любом случае будет считаться ключевым словом

К примеру: «увеличение конверсии» или «увеличить конверсию» ( одно и тоже ), так же не имеет значение окончания слов.

Числа писать цифрами или прописью

Имеет значение, но не большое. Долго пытался выяснить, в каких случаях имеет значение, но алгоритма не выявил. Могу сказать одно, что в как число не напиши, оно будет считаться ключевым словом.

В 70 из 100 запросов было не важным как написать число, цифрами или прописью, если есть текст перед числом или после числа. Удивило безразличие к цифрам от Яндекса, когда вам нужно найти 2 способа, поисковый алгоритм может выдать сайт, где будет описан просто «второй способ», а на самой странице окажется 10 способов.

Использование ошибок в словах

При написания слова с ошибкой идёт автоматическое исправление и показывает запросы без ошибок. Однако, если отменить исправление, то мы увидим лишь те сайты, где были допущены такие ошибки.

Использование синонимов

Синонимы так же выделяются в выдаче, как и ключевые слова. К примеру «увеличение конверсии» , синоним повышение. Очень часто можно встретить использование синонимов в сниппете.

Наименование кириллицой или латинскими буквами

Поисковые системы (ПС) научились хорошо распознавать слова написанные. К примеру, Google можно написать как Гугл, что будет являться одним и тем же словом для ПС.

Использования Аббревиатуры в тексте

Яндекс легко распознаёт аббревиатуры, с использованием тематического уклона. К примеру аббревиатура CTR может трактоваться по разному, однако для вебмастеров CTR – это click through rates. В Google такая система не работает.

Получение в cURL страниц со сжатием

Иногда при использовании cURL появляется предупреждение:

Warning: Binary output can mess up your terminal. Use "--output -" to tell Warning: curl to output it to your terminal anyway, or consider "--output Warning: <FILE>" to save to a file.

Его можно увидеть, например при попытке получить страницу с kali.org,

curl https://www.kali.org/

Суть сообщения в том, что команда curl выведет бинарные данные, которые могут навести бардак в терминале

Нам предлагают использовать опцию «—output -» (обратите внимание на дефис после слова output – он означает стандартный вывод, т.е. показ бинарных данных в терминале), либо сохранить вывод в файл следующим образом: «—output «.

Причина в том, что веб-страница передаётся с использованием компрессии (сжатия), чтобы увидеть данные достаточно использовать опцию —compressed:

curl --compressed https://www.kali.org/

В результате будет выведен обычный HTML код запрашиваемой страницы.

Google все определяет сам

Как всегда, Google и только Google будет выбирать ответы, которые он показывает в результатах поиска, если он вообще их показывает. В конце концов, нет волшебной формулы для избранных сниппетов. Google говорит, что алгоритмы, стоящие за этим, постоянно меняются. Даже способ, которым он находит и представляет избранные сниппеты, не постоянный.

Например, Google почти наверняка учитывает вовлеченность и рейтинг кликов при определении того, какой ответ присудить блоку избранных сниппетов. Но есть также случаи, когда Google выбирает ответ с сайта на второй странице результатов или даже дальше по списку. В конце концов, все всегда сводится к одному простому вопросу: «Мой ответ доставлен?»

Красивые сниппеты позволят вам взобраться на вершину результатов

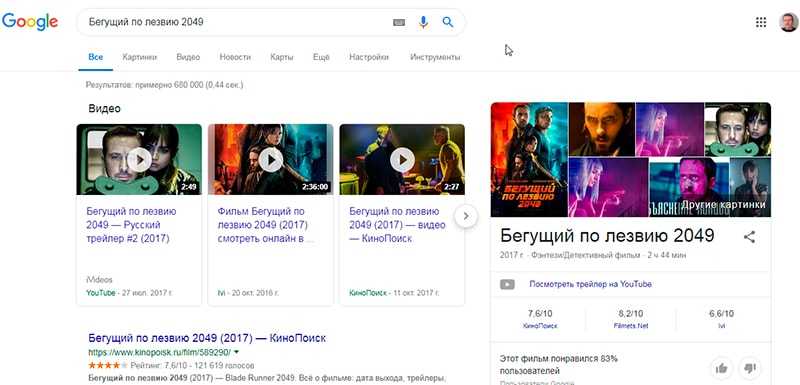

Теперь, чтобы понять ценность избранных сниппетов, важно увидеть, как и где они расположены на странице результатов поиска. Такая страница состоит из нескольких частей, в том числе обыкновенных результатов поиска, объявлений и одного или нескольких динамических блоков поиска

Google все чаще пытается удерживать как можно больше кликов или отправлять их рекламным партнерам.

Объявления и результаты встроенного поиска, такие как: поля ответов, избранные сниппеты, элементы базы знаний и т. д. Все это еще больше запутывает результаты обычного поиска. Для определенных отраслей и поисков это оставляет намного меньше пространства для того, чтобы ваши органические результаты наконец-то хорошенько засветились.

Возьмем все тот же пример ― «Бегущий по лезвию 2049», который был уже упомянут вначале. Посмотрите на скриншот ниже, и вы поймете, о чем речь. Да, это исключительный пример, но он доказывает эту точку зрения. К счастью, мы можем попытаться получить избранные сниппеты, чтобы принести нам дополнительный поток трафика. Не говоря уже о том, что ответы на вопросы ― это отличный способ подготовить ваш контент для голосового поиска.

Лучшие библиотеки веб-скрапинга Python

Можно создать скрипт веб-парсера с нуля с помощью ванильного Python, но это не идеальное решение. В конце концов, Python известен своим обширным выбором пакетов и, в частности, есть масса библиотек для веб-скрапинга. Пришло время рассмотреть наиболее важные из них!

Requests

Библиотека Requests позволяет выполнять HTTP-запросы на языке Python. Она упрощает отправку HTTP-запросов, особенно по сравнению со стандартной библиотекой Python HTTP. Requests играет ключевую роль в проекте для веб-скрапинга на Python. Это связано с тем, что для сбора данных, содержащихся на странице, необходимо сначала получить их с помощью HTTP-запроса GET. Кроме того, возможно, придется выполнить и другие HTTP-запросы к серверу целевого сайта.

Установить Requests можно с помощью следующей команды pip:

Beautiful Soup

Python-библиотека Beautiful Soup упрощает сбор информации со страниц. В частности, Beautiful Soup работает с любым HTML- или XML-парсером и предоставляет все необходимое для итерации, поиска и модификации абстрактного синтаксического дерева

Обратите внимание, что Beautiful Soup можно использовать вместе с html.parser — парсером, входящим в стандартную библиотеку Python и позволяющим парсить текстовые HTM-файлы. В частности, Beautiful Soup помогает обходить DOM и извлекать из него нужные данные

Установить Beautiful Soup с помощью программы pip можно следующим образом:

Selenium

Selenium — современная система автоматизированного тестирования с открытым исходным кодом, позволяющая выполнять операции на странице в браузере. Другими словами, с его помощью можно поручить браузеру выполнение определенных задач

Обратите внимание, что Selenium также можно использовать в качестве библиотеки для веб-скрапинга благодаря его возможностям «безголового» браузера. Если вы не знакомы с этим понятием, то речь идет о веб-браузере, работающем без графического интерфейса пользователя (GUI)

Если Selenium настроен в безголовом режиме, он будет запускать управляемый браузер, образно говоря «закулисно».

Интернет-страницы, посещаемые в Selenium, отображаются в реальном браузере. Таким образом, Selenium поддерживает веб-парсинг страниц, которые используют JavaScript для рендеринга или получения данных. Selenium предоставляет все необходимое для создания парсера, не требуя использования других библиотек. Установить его можно с помощью следующей команды pip:

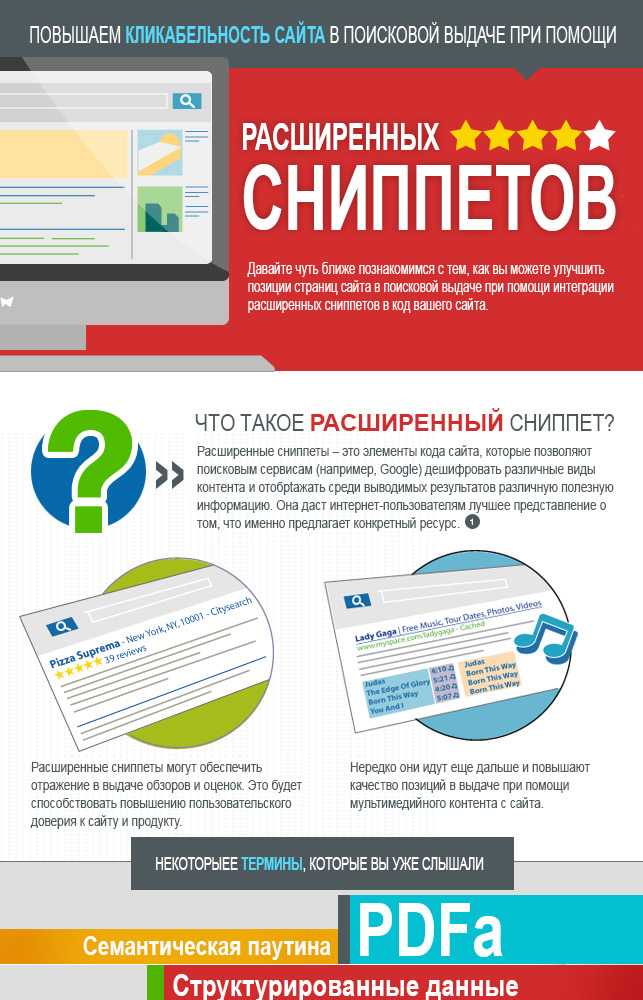

Расширенные результаты и SEO

С самого начала следует обозначить, что само по себе наличие микроразметки на сайте не является фактором ранжирования в Google. Но алгоритмы и требования поисковой системы постоянно меняются, и не исключено, что роль микроразметки станет более значительной для продвижения. Какие же преимущества предоставляет оптимизация под расширенные сниппеты в настоящий момент?

Расширенные результаты затмевают обычные за счет дизайна и дополнительной информации и занимают больше места в выдаче

На их фоне обычным сниппетам сложнее привлечь внимание пользователей.

Пользователи Google чаще кликают по расширенным результатам — по данным исследования американской компании Milestone Inc, 58% предпочитают именно расширенные сниппеты. Это дает основание рассчитывать на дополнительное увеличение трафика в случае удачной оптимизации под них.

Расширенные сниппеты убирают барьеры между бизнесом и потребителем

Например, если пользователи могут просмотреть рейтинги, фото, место расположения и номер телефона ресторана прямо в выдаче, то им незачем переходить на сайт. С помощью интерактивных результатов поиска они смогут забронировать столик прямо со страницы выдачи.

Если расширенные результаты уже отображаются по вашим целевым запросам, то вам придется их учитывать в своей стратегии продвижения. Особенно это актуально для оптимизации сайтов под рынок США и Европы, где выдача уже пестрит всеми возможными видами сниппетов.

Теперь SEO-специалистам не достаточно знать количество запросов и конкуренцию по ним. Нужно еще проверять, какие виды расширенных результатов Google показывает для каждого запроса, насколько активно люди взаимодействуют с этими результатами и есть ли смысл оптимизировать страницы под них.

Как изменить сниппет в поисковых системах

За счет чего формируется сниппет? А строится он, прежде всего, за счет очень важного мета тега description, про который все новички вечно забывают, поскольку им кажется, что его заполнять не так важно. Ещё хуже, когда вебмастеры просто перечисляют в нем список ключевых слов

Вернемся к description. Синтаксис этого мета тега:

Допустим он у Вас заполнен по всем правилам, но это вовсе не стопроцентная гарантия, что поисковая система (имеется ввиду Яндекс) будет использовать Ваше описание «description». Вот в Google ситуация со сниппетами предельна проста. То, что написано в description, то он и отображает.

С Яндексом все сложнее. Для него этот мета тег является лишь рекомендацией, а не правилом. Его алгоритмы зачастую сами составляют описание для страницы путем вырезания кусков текста на странице. В некоторых случаях это получается хорошим описанием, но бывает и не очень. Поэтому надеяться на алгоритмы не стоит. Лучше перепроверять иногда их самостоятельно или же воспользоваться такой функцией в Яндекс Вебмастер.

Как же все-таки можно повлиять на сниппет в Яндексе, если он его сгенерировал сам? Ну, как это не странно звучит, для начала нужно обязательно прописать хороший мета тег description. Если это не помогло и сниппет все равно берется из текста страницы, то остается только одно: найти этот кусок текста на странице и отредактировать его так, чтобы получить привлекательное описание страницы. Скажу сразу, что порой это бывает не простой задачей (например, может быть склеен заголовок <h1> и сразу следующее за ним первое предложение). Однако ради результата стоит повозиться с контентом.

Если очень много страниц на сайте

Как и контент на каждой странице должен быть уникальным, так и описание страницы должно быть уникальным. Но что делать, если на сайте тысячи страниц? Ведь поменять все сниппеты на таком гиганте будет очень трудоемкой задачей. Да и трудно придумать так много различных описаний, которые бы ещё и отвечали всем требованиям. В этом случае поступают несколько более простым способом:

- Отбираются запросы, которые располагаются ближе всего к топу. На мой взгляд, достаточно будет найти все запросы в топ30.

- Далее проверяете сниппеты этих страниц на привлекательность. Если Вы считаете, что менять ничего не нужно, то переходите к следующему запросу (но лично я чаще всего нахожу способы переписать сниппет в более лучшем виде).

- Через месяца два советую проверить эти запросы. Стал ли отображаться именно тот сниппет, к которому Вы стремились? Если да, то могу вас поздравить с достижением поставленной цели.

Даже после одной такой итерации можно получить существенное улучшение видимости сайта в поисковых системах при незначительных затратах времени и денежных средств. Поэтому советую оптимизировать свои проекты, в особенности те запросы, которые нужно продвинуть, поскольку это просто необходимо в нынешних условиях SEO.

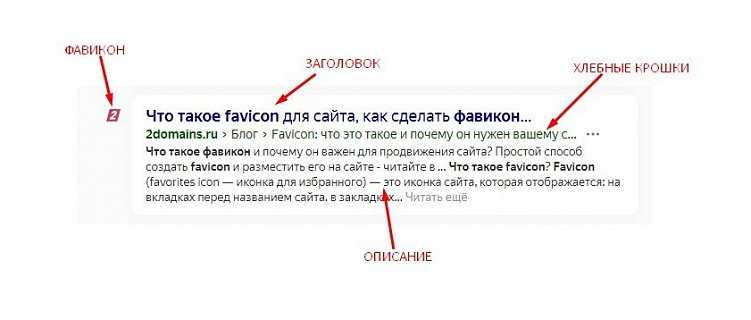

Оформляет snippet правильно

Заливаем узнаваемый фавикон. Добавить favicon в виде логотипа дело несложное, однако, скорее всего это будет малоразличимый элемент, больше напоминающий пиксельную кашу.

Создаем броский заголовок

Первое, на что обращает внимание потенциальный посетитель, это заголовок. Прочитав его, он принимает решение о переходе на ресурс.

Пишем релевантное описание. Если заголовок не мотивировал пользователя перейти на сайт, то он начинает читать описание. Чем понятнее оно будет написано, тем больше вероятность, что переход в итоге состоится.

Описание формируется на основе тега description, поэтому важно заполнить его правильно. Соблюдаем размер 220-250 символов, пишем описание релевантное поисковым запросам, максимально информативно, краткими словосочетаниями описываем суть страницы. Делаем микроформатную разметку

Разметка покажет поисковикам структурированные данные и выведет в сниппет определенную информацию.

Делаем микроформатную разметку. Разметка покажет поисковикам структурированные данные и выведет в сниппет определенную информацию.

Виды сниппетов в выдаче и их влияние на трафик

Есть всего два вида сниппетов сайта: стандартные и расширенные.

В стандартном сниппете четыре элемента:

-

Заголовок (название). За его формирование отвечает метатег Title: что напишете там, то и будет в сниппете.

-

Описание. Можно добавить его в метатег Description, но поисковые системы могут формировать его сами из текста на странице.

-

Фавикон — небольшое изображение сайта.

-

Хлебные крошки — путь до страницы, на которую перейдет пользователь.

Эти элементы есть и в «Яндексе», и в Google.

Так выглядит стандартный сниппет в поисковой выдаче «Яндекса»

В расширенных сниппетах могут быть дополнительные элементы. Например, адрес компании или изображение. Благодаря этому они занимают больше места в поисковой выдаче.

Специалисты до сих пор спорят о необходимости расширенных сниппетов. Исследование SEOquick , что они негативно сказываются на кликабельности. Исследование Ahrefs подтвердило, что в расширенных сниппетах пользователи могут сразу узнать ответ на вопрос, поэтому они не переходят на сайт.

Эксперимент MOZ напротив показал, что сайты со стандартными сниппетами получают меньше трафика. Когда ресурс отказался от расширенных сниппетов, число переходов из Google снизилось на 12%.

Как сделать сайт более продуктивным: 10 рекомендаций от экспертов

Вывод

Если вы занимаетесь продвижением собственного сайта или ведением клиентских проектов, попробуйте на практике инструмент парсинга выдачи от PromoPult. Он позволяет проверить позиции сайта в Яндексе и Google в заданных регионах в мобильный и десктопной выдаче.

Кроме того, здесь есть уникальный функционал, который вы не найдете в других чекерах позиций, — бесплатное сравнение позиций с конкурентами, парсинг данных из Яндекс.Директа, сниппетов, подсветок и колдунщиков. Мониторить позиции можно одноразово или по расписанию.

Хотите протестировать инструмент без затрат?

Доступна бесплатная проверка по 100 запросам.

Заключение

- Для начала проверить наличие и адекватность всех материалов на сайте (это более приоритетная задача)

- Проверьте наличие красивого favicon`а

- Подумайте над использованием специальных символов в title (может быть всего один и не на всех страницах, например если ваш логотип звезда, то спец.символ “Закрашенная звезда” может вам подойти, а ваши посетители начнут в поиске ориентироваться на ваш спец. символ)

- Следующее действие — изучение библиотеки schema.org

- Далее применяем полученные знания о микроразметке для формирования правильных хлебных крошек в сниппете

- После создания хлебных крошек или другой микроразметки не забываем проверить валидатором:

www.google.com/webmasters/tools/richsnippetswebmaster.yandex.ru/microtest.xml

Регистрируем свой сайт в Яндекс и Google Вебмастерах и настраиваем Быстрые ссылки

Обязательно зарегистрироваться на “Картах” и в “Организациях”

Разместить Юр

информацию о вашей организации на страничке “Контакты”

После обязательно обратите внимание на список возможностей по расширению сниппета

Дополнительные материалы:этой инфографике

![Как снимать позиции сайта и парсить выдачу без лишней рутины [инструкция promopult] | web-sovety.ru](http://susaninskaya.ru/wp-content/uploads/8/6/a/86ad418d58a8042b0a6e082c3ed4ec3e.jpeg)